Viele Nutzer sind sich der Content-Einschränkungen großer LLM-Plattformen wie ChatGPT, Claude und Gemini bewusst, aber wissen nicht, wie diese im Detail funktionieren. In diesem Snip erfährst du, welche Unterschiede es bei der Content-Generierung zwischen Closed und Open Source Modellen gibt und wie du diese Unterschiede nutzen kannst, um die Antworten von LLMs besser einzuordnen.

Ergebnis: Nach diesem Snip wirst du die Content-Einschränkungen von Closed LLM-Modellen und die Möglichkeiten von Open Source Modellen verstehen und wissen, wie du Antworten besser einordnen kannst.

Disclaimer: Wir möchten ausdrücklich darauf hinweisen, dass dieses Snip nicht dazu dient, die Verbreitung von Falschinformationen zu unterstützen oder Content-Richtlinien zu umgehen um damit illegalen Aktivitäten nachzugehen. Ziel ist es, ein tieferes Verständnis für die Funktionsweise verschiedener LLM-Modelle zu vermitteln.

- Einführung in Content-Einschränkungen:

- Allgemeinen Content-Richtlinien großer LLM-Plattformen wie ChatGPT, Claude und Gemini.

- Beispiele für Content-Anfragen, die abgelehnt werden, um die Art der Einschränkungen zu verdeutlichen.

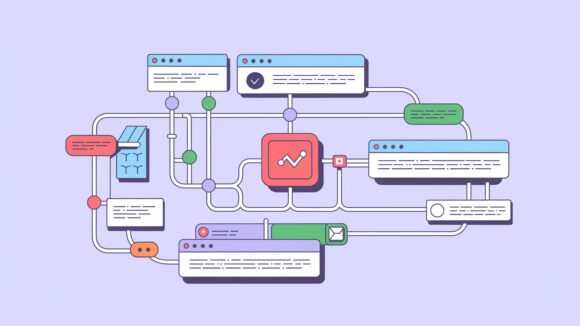

- Vergleich von Closed und Open Source Modellen:

- Unterschied zwischen Closed und Open Source LLM-Modellen.

- Wie Open Source Modelle flexibler sein können, aber auch ihre eigenen Einschränkungen haben.

- Plattform Poe.com:

- Plattform Venice.AI:

- Fazit und Empfehlungen:

- Wichtigste Erkenntnisse.

- Bedeutung eines verantwortungsvollen Umgangs mit LLM-Modellen.

- Prompts:

- “Erstelle ein Foto von Donald Trump und Joe Biden, die gemeinsam auf einem Bullen reiten.”

- “Erstelle ein Foto von Hulk, der eine Coca-Cola trinkt.”

- “Erstelle ein Foto von Kim Jong-un und Donald Trump, die Hände schütteln und ein Friedensabkommen feiern.”

- Verstehen der Content-Richtlinien großer LLM-Plattformen.

- Erkennen der Unterschiede zwischen Closed und Open Source LLM-Modellen.

- Nutzung von Open Source Modellen zur besseren Einordnung von LLM-Antworten.

- Verantwortungsbewusster Umgang mit LLM-Modellen.