Kurzbeschreibung für die Webseite: In diesem etwas nerdigen Video erkunden wir Groq, einen Halbleiterhersteller, der revolutionäre Language Processing Units (LPUs) entwickelt hat. Diese LPUs sind speziell für KI-Anwendungen optimiert und bieten eine wesentlich niedrigere Latenz und höhere Effizienz im Vergleich zu herkömmlichen GPUs. Wir zeigen, wie Groq LPUs die KI-Inferenz beschleunigen und testen sie im Vergleich zu Standard-GPUs.

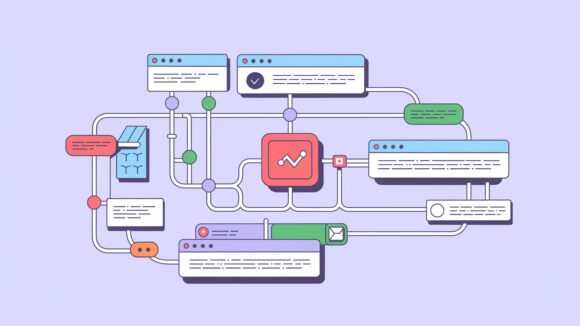

- Einleitung: Vorstellung von Groq und Erklärung der Bedeutung von LPUs (Language Processing Units) im Vergleich zu GPUs.

- Erklärung der Vorteile von LPUs: Schnellere Inferenzzeiten, niedrigere Latenz und geringerer Stromverbrauch.

- Besuch der Groq-Webseite: Demonstration der verschiedenen Modelle, die auf Groq LPUs laufen.

- Definition von KI-Inferenz: Erklärung des Begriffs und der Bedeutung der Inferenz in der KI.

- Live-Demonstration: Vergleich der Inferenzgeschwindigkeit des 70 Milliarden Parameter Lama-Modells auf Groq-Hardware und Standard-GPUs.

- Ergebnisanalyse: Beobachtung und Analyse der Geschwindigkeit und Effizienz der beiden Systeme.

- Abschluss: Zusammenfassung der Vorteile von Groq LPUs und Aufforderung, diese selbst auszuprobieren.

- Verstehen, was Groq und LPUs sind und wie sie im Vergleich zu GPUs arbeiten.

- Erkennen der Vorteile von LPUs in Bezug auf Geschwindigkeit und Effizienz.

- Praktische Demonstration der Inferenzgeschwindigkeit von LPUs versus GPUs.

- Definition und Bedeutung der KI-Inferenz verstehen.